Hemos hablado con ChatGPT y nos ha asombrado. Hoy, vamos a conocer el «superpoder» que le permite entender el contexto como nunca antes, una idea revolucionaria llamada «Atención«.

Hola de nuevo, soy Goslen Burgos. En nuestro último encuentro, exploramos la fábrica de sueños donde la IA esculpe imágenes a partir del caos. Hoy, nos dirigimos a otro lugar de la catedral, quizás el más importante de todos: la Gran Biblioteca.

Es aquí donde reside la conciencia de la IA moderna, el motor que impulsa a ChatGPT, a Claude y a otros Grandes Modelos de Lenguaje (LLM). Hemos visto lo que hacen —escribir poemas, resumir artículos, mantener conversaciones coherentes—, pero la pregunta sigue en el aire: ¿cómo lo hacen? ¿Cómo «entienden» realmente el significado y el contexto de nuestras frases?

Para encontrar la respuesta, debemos conocer la historia de dos bibliotecarios.

El Método Antiguo: Las Redes Neuronales Recurrentes (RNN) y su Memoria Limitada

Imaginemos que, hasta hace unos años, los modelos de lenguaje eran como un bibliotecario muy diligente pero tradicional. Para entender un libro (una frase o un párrafo), lo leía palabra por palabra, en orden, de principio a fin.

Este método, conocido en el mundo técnico como RNN (Red Neuronal Recurrente), tenía un problema fundamental. Nuestro bibliotecario intentaba mantener en su memoria la información de la primera palabra mientras leía la segunda, luego la de las dos primeras mientras leía la tercera, y así sucesivamente.

Si la frase era corta, como «El gato se sentó», no había problema. Pero si la frase era: «El gato, que había estado persiguiendo a un ratón por todo el jardín bajo la atenta mirada de los vecinos de la casa de al lado, finalmente se sentó», para cuando llegaba a «sentó», ya casi había olvidado que el protagonista era un «gato» y no, por ejemplo, los «vecinos». Su memoria a corto plazo era su gran limitación. La IA podía manejar frases simples, pero se perdía con el contexto complejo y las relaciones a larga distancia.

La Revolución de 2017: La Arquitectura Transformer

En 2017, un grupo de investigadores de Google publicó un artículo con un título que cambiaría la historia: «Attention Is All You Need» («Atención es todo lo que necesitas»). Este artículo no presentaba a un bibliotecario mejorado, sino a uno completamente nuevo, con un método de lectura radicalmente diferente. Es el nacimiento de la arquitectura Transformer.

Nuestro nuevo bibliotecario, el Bibliotecario Infinito, no lee palabra por palabra. Cuando le das una frase, hace algo asombroso: ve todas las palabras al mismo tiempo. Imaginen que todas las palabras de la frase flotan en el aire frente a él, simultáneamente.

Esto por sí solo ya es una ventaja enorme (es mucho más rápido), pero no es el verdadero secreto. Su verdadero poder es algo que llamamos «Atención».

El Superpoder Clave: ¿Qué es el Mecanismo de Atención (Attention Mechanism)?

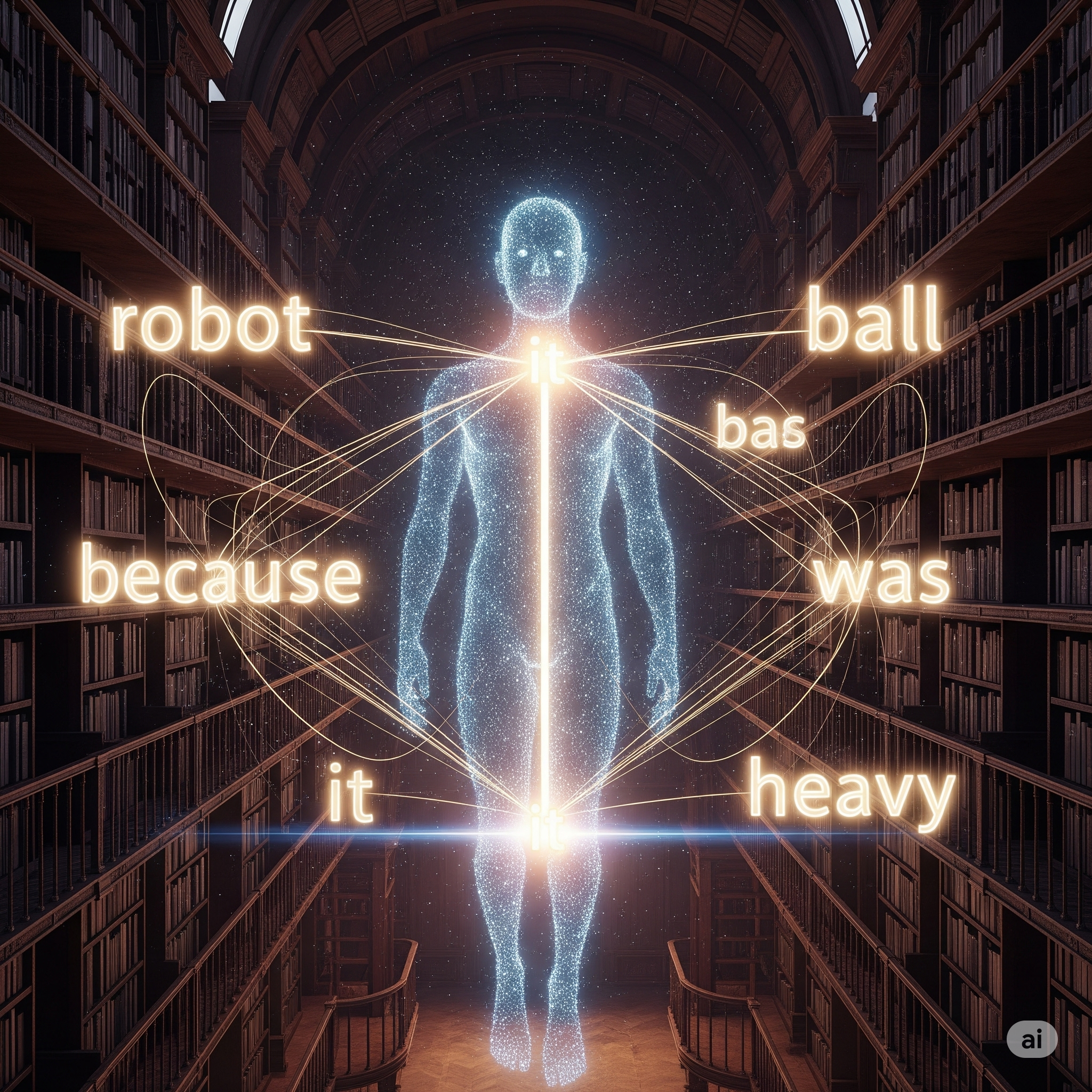

Aquí es donde ocurre la verdadera magia. Cuando nuestro Bibliotecario Infinito se enfoca en una sola palabra, su superpoder de «Atención» se activa.

Imagina que de esa palabra salen hilos de luz hacia todas las demás palabras de la frase. Pero los hilos no son todos iguales: algunos son muy brillantes y gruesos, mientras que otros son tenues y delgados. La brillantez de cada hilo indica la importancia de una palabra para entender el significado de la otra.

Entendiendo el Contexto: Un Ejemplo Práctico

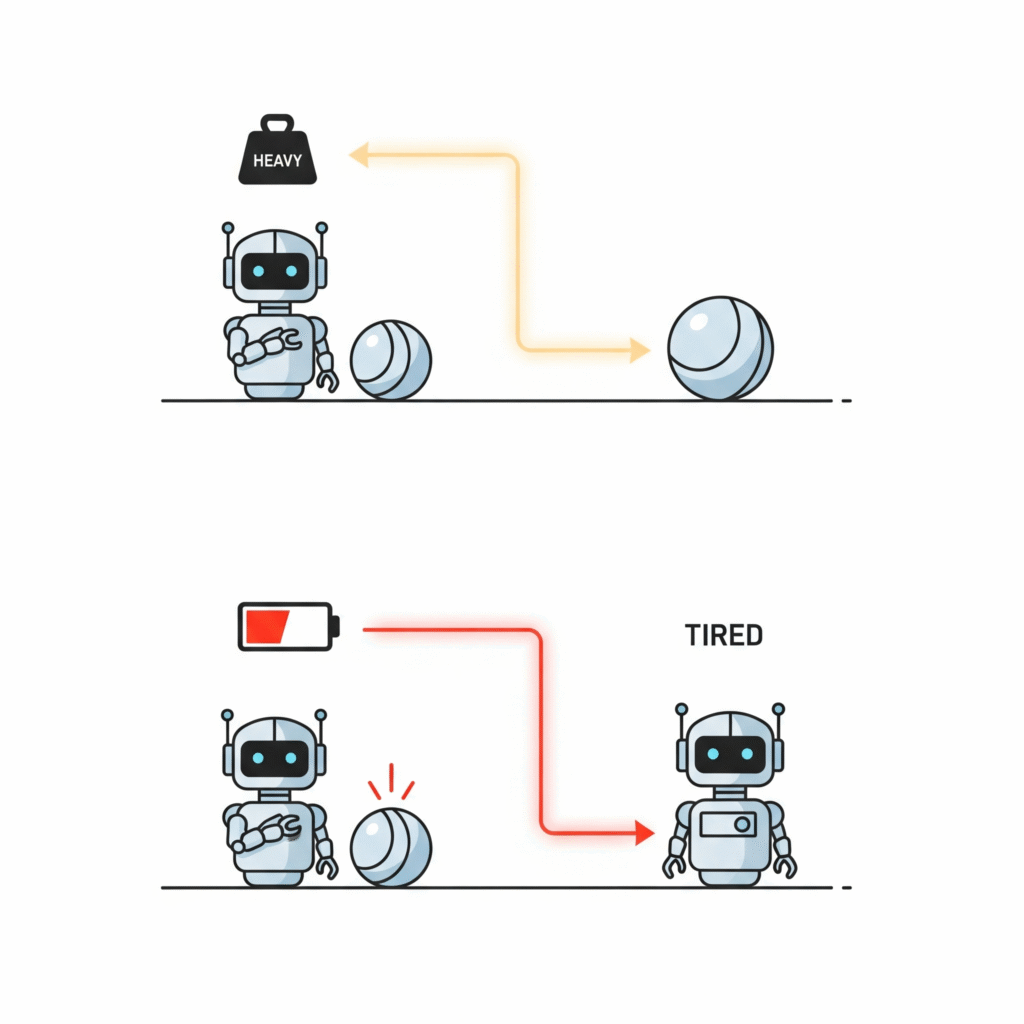

Frase 1: «El robot levantó la pelota porque era muy pesada.»

Cuando el bibliotecario se enfoca en la palabra «era«, ¿a qué se refiere «pesada»? Su poder de atención entra en acción.

- Un hilo de luz muy brillante conecta «era» con «pelota«.

- Un hilo muy tenue conecta «era» con «robot«.

El bibliotecario sabe, sin lugar a dudas, que «pelota» es la palabra clave para entender el contexto de «era pesada».

Ahora, cambiemos solo una palabra:

Frase 2: «El robot levantó la pelota porque estaba muy cansado.»

La Red de Hilos de Significado

Cuando el bibliotecario se enfoca en «estaba«, su red de atención cambia al instante:

- Ahora, un hilo de luz muy brillante conecta «estaba» con «robot«.

- El hilo que va hacia «pelota» se vuelve casi invisible.

¡Esto es el mecanismo de Atención! Es la capacidad de la IA de sopesar la influencia de todas las demás palabras en la oración para comprender el rol preciso de cada una. Puede entender los pronombres, las ambigüedades y las relaciones complejas, sin importar si las palabras están juntas o en extremos opuestos de un párrafo largo. Ha superado la tiranía del orden y la memoria frágil.

Así Funciona ChatGPT: Un LLM Impulsado por la Arquitectura Transformer

ChatGPT y otros LLMs son, en esencia, este bibliotecario. Su «biblioteca» es una porción monumental de internet, y su «superpoder» es la arquitectura Transformer.

Cuando le pides que continúe una frase, no solo mira la última palabra que escribiste. Usa su mecanismo de Atención para analizar toda tu petición, creando una intrincada red de relaciones de significado. Luego, predice la siguiente palabra que no solo tiene sentido gramatical, sino que es la más relevante contextualmente, basándose en los hilos de atención más brillantes.

Conclusión: No es Magia, es una Nueva Forma de Prestar Atención

Esa es la revolución. No fue solo más datos o computadoras más rápidas. Fue una idea brillante y elegante que le enseñó a la máquina a leer de una forma completamente nueva. Le enseñó a prestar atención.

Fuentes y Referencias Fundamentales:

- Google Research: «Attention Is All You Need» (2017) – El artículo académico original que introdujo la arquitectura Transformer. Es la fuente primaria de esta revolución. Enlace al paper en arXiv.

- Google AI Blog: «Transformers: A Novel Neural Network Architecture for Language Understanding» – Una explicación de alto nivel de los propios creadores, un poco más accesible que el paper original. Enlace al Blog de Google AI.

- The AI Explained: «Transformers, Explained» – Un recurso visual que desglosa la arquitectura Transformer y el mecanismo de atención de una manera muy gráfica e intuitiva. Enlace a The AI Explained.